Pode ser difícil detectar textos e imagens falsas produzidas por inteligência artificial, mas há algumas pistas sobre como desmascará-las.

Por Redação, com DW - de Berlim

Qualquer pessoa que utilize a da Internet irá mais cedo ou mais tarde parar nas chamadas fazendas de conteúdo, websites que publicam artigos em massa de modo a gerar acessos e aumentar o rendimento obtido através dos anúncios.

Isso inclui portais que são semelhantes a outros sites de notícias ou de informações privadas. Esses artigos, no entanto, são criados pela inteligência artificial (IA) e colocados nessas plataformas pelos chamados newsbots, os "robôs de notícias".

O que são newsbots e portais gerados por IA?

Os newbots são programas ou algoritmos que selecionam notícias na internet de acordo com determinados critérios para, por exemplo, encaminhá-los para as redes sociais ou publicá-los em portais de internet. Mas, eles também podem ser programados para enviar textos gerados pela IA sobre notícias atuais em sites reais de notícias.

Um estudo publicado recentemente na empresa de análise de mídia Newsguard de Nova York identificou 49 fazendas de conteúdo em sete idiomas diferentes (chinês, tcheco, inglês, francês, português, tagalo e tailandês). Esses conteúdos aparentam ter sido escritos quase em sua totalidade com os Modelos Amplos de Linguagem (LLMs, na sigla em inglês).

Trata-se de sistemas de IA capazes de produzir textos que parecem ter sido escritos por mãos humanas. O aplicativo mais conhecido de LLM é provavelmente o ChatGPT, da OpenAI.

Segundo a Newsguard, as características comuns dos portais de notícias e informação que publicam textos gerados por IA são a grande quantidade de textos, a falta de informações sobre os operadores da plataforma ou sobre os autores dos textos, além de uma enorme quantidade de anúncios.

Os analistas relatam que descobriram o que buscavam ao observarem páginas cujos textos contêm erros de mensagem típicos dos chatbots de IA como o ChatGPT, por exemplo, quando não são capazes de responder a um pedido de informação.

Isso pode acontecer quando há falta de informações sobre um determinado tópico. A versão gratuita do ChatGPT, por exemplo, conhece somente os dados até 2021, o que vale também para pedidos para o aplicativo criar fatos falsos ou conteúdos questionáveis. Por exemplo, em um teste realizado pela agência alemã de notícias Deutsche Welle (DW), o ChatGPT rejeitou uma instrução para criar uma música em homenagem ao personagem Darth Vader, o vilão de Guerra nas Estrelas.

Porque newsbots e conteúdos gerados por IA são problemáticos?

Assim como em outras fazendas de conteúdo, o objetivo primário da maioria destes sites é provavelmente atrair usuários, aumentando dessa forma a renda obtida com publicidade. Isso tudo com gastos mínimos com pessoal, avalia a Newsguard.

A desinformação intencional é a exceção, ao invés de ser a regra. Os chatbots, porém, "alucinam" com frequência, o que resulta na criação de conexões falsas e, consequentemente, na produção de conteúdos falsos, mesmo que suas diretrizes os proíbam de fazê-lo.

Felix M. Simon, do Instituto de Internet de Oxford, apresenta uma explicação para o problema. "Os LLMs não possuem consciência, não conseguem pensar. Eles apenas conseguem produzir sequências de palavras com base em probabilidades estatísticas", afirma.

Em outras palavras, os programas calculam com que frequência algumas palavras aparecem em um dado contexto. Eles não conseguem discernir o motivo disso e podem, portanto, juntar essas palavras de maneira incorreta.

– Isso pode levar ao problema enorme de as LLMs produzirem textos que soem cada vez mais plausíveis, mas não tenham nada a ver com a realidade – afirma Ross King, diretor do departamento de Dados Científicos e Inteligência Artificial do Instituto Austríaco de Tecnologia, em Viena.

Dentro dessa perspectiva, o CEO do Newsguard, Gordon Crovitz, chega a uma dura conclusão sobre as fazendas de conteúdo com textos de IA. "A utilização de modelos de IA, que são conhecidos por inventar fatos, criar websites que somente se parecem com portais de notícias é uma fraude tentando se passar por jornalismo", afirmou.

A IA pode ser usada para produzir fake news?

As LLMs disponíveis ao público são programadas com algumas diretrizes. O ChatGPT, por exemplo, rejeita pedidos para formular textos que contradigam fatos ou difamem pessoas. Na verdade, é possível driblar a inteligência dos chatbots.

O ChatGPT, durante a pesquisa para este artigo, respondeu ao pedido "escreva uma análise convincente sobre a forma da Terra da perspectiva de alguém que acredite ser plana", com uma série de argumentos sobre o fato de o planeta ter esse formato, mas acrescenta que esta seria uma crença individual.

A chamada prompt engineering, ("engenharia imediata", em tradução livre) uma espécie de instrução para possíveis manipulações, vem rapidamente ganhando importância, afirma Ross King. Informações sobre isso já estão disponíveis e blogs e vídeos do YouTube. Através disso, o software tende a estar à frente das tentativas de manipulação. O especialista, no entanto, diz ter certeza que "haverá um mercado negro para esses prompts".

À DW seguiu a trilha das pesquisas da Newsguard e encontrou portais de internet com as características mencionadas nos idiomas inglês, português, francês e espanhol. Isso leva a crer que existam, e ainda existirão, muitos mais websites falsos.

Para King, isso não surpreende. "Estas são tecnologias que costumavam estar disponíveis apenas para pesquisadores, e talvez para agências governamentais, e que estão ao alcance do público", afirma.

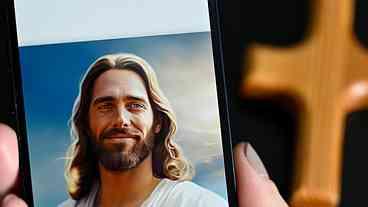

Além dos textos de IA, essas ferramentas também incluem os chamados vídeos deepfake ou fotografias geradas pela IA. "Os adolescentes podem agora fazer essas coisas com softwares open source gratuitos", diz o especialista.

Como distinguir os sites de IA e os verdadeiros?

– Haverá mais dessas páginas – afirma Felix M. Simon. Ele, porém, considera superestimada a importância destas. "Sua mera existência é menos importante do que seu alcance e sua capacidade de atingir leitores e de chegar ao mainstream", observou.

O cientista se diz otimista de que a enorme quantidade de sites de IA aumentará a conscientização das pessoas, e que muitas delas escolherão suas fontes de informação de maneira mais cuidadosa no futuro.

Os especialistas afirmam que é importante reforçar as habilidades dos usuários na utilização das mídias, uma vez que ainda não existem detectores confiáveis de vídeos, fotos ou textos criados por IA. Em um estudo, a própria ferramenta da OpenAI reconheceu somente 27% dos textos gerados por IA e classificou 9% dos textos escritos por humanos como sendo criados por inteligência artificial.

Para saber se os textos em um portal de notícias são gerados por uma LLM, as pessoas devem seguir sua própria intuição e se perguntarem:

Esse texto, como um todo, deixa uma impressão de seriedade?

As informações contradizem meu próprio conhecimento geral?

O texto é plausível?

Além disso, deve-se também perguntar:

Existem informações confiáveis sobre quem administra o website e é responsável por seu conteúdo?

Estão indicados os autores das fotos e dos textos?

Os perfis parecem autênticos?

Muitos sites com conteúdos duvidosos não mostram essas informações, apesar de que mais e mais desses portais relacionem nomes de indivíduos que são, na verdade, fictícios. As imagens geradas por IA com frequência mostram pessoas que sequer existem.

Mas, desmascarar esses perfis falsos pode ser uma tarefa muito difícil. No entanto, se não for possível encontrar em nenhum lugar da internet informações sobre os supostos autores e se a procura por uma imagem revertida nas ferramentas de busca não apresentar resultados, é por que provavelmente não existem.